新智元报导

来历:ZDNet

修改:亮亮

【新智元导读】现在,算法的运用现已十分遍及,可是对大部分人并不知道算法的决议计划原理和依据。对此,谷歌近来推出了“ Explainable AI”,协助用户了解算法的决议计划原因、依据和进程,来使得算法愈加通明。经过这个东西,用户都能够看到各个算法是怎样完成的。来新智元AI朋友圈和AI大咖们一同评论吧。

尽管大大都人每天都会遇到算法,但没有多少人能够说他们真的了解AI的实际工作原理。可是,Google推出了一种新东西,期望能够协助普通人把握机器学习的复杂性。

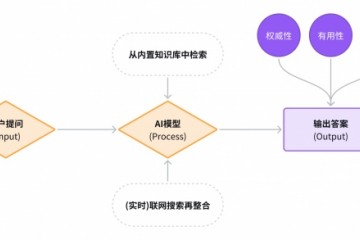

该东西被称为“可解说AI”(Explainable AI),它能够向用户解说机器学习模型的处理成果是怎么得出以及为什么得出决议计划的。

谷歌表明,这样做将用户愈加信赖机器学习模型。这一点很重要,之所以大大都现有模型往往适当不通明,是因为大都用户不清楚他们怎么做出决议。

可解说AI给算法打分、量化数据要素,让你更懂算法

为此,可解说AI东西将量化数据会集每个特征对算法成果的奉献,每个数据因子都会有一个分数,来反映了它对机器学习模型的影响程度。

用户都能够拉出该分数,来了解给定算法为何做出特定决议计划。例如,关于决议是否同意或人借款的算法模型,“可解说AI”将显现帐户余额和信誉评分作为最决议性决议计划的依据数据。

谷歌云首席执行官托马斯·库里安(Thomas Kurian)在伦敦的Google活动中介绍了该新功用,他说:“如果您运用AI进行信誉评分,您会想知道为什么算法模型依据信誉评分经过这个人却拒绝了别的一个。”

他说:“关于在企业的业务流程中运用人工智能的客户,‘解说AI’能够在必定程度上协助您了解为什么人工智能根底架构能够发生特定的成果。”换句话说,“可解说AI”能否精确解说特定机器学习模型为何得出结论,关于企业中担任终究决议计划的高管来说很重要。关于高度严厉的职业来说,能够信任AI作出的决议计划是至关重要的。

“可解说AI”现在能够用于保管在Google的AutoML Tables 和Cloud AI Platform Prediction上的机器学习模型。

此前,谷歌也曾采纳办法使算法愈加通明。上一年,它推出了“假定东西”,供开发人员在运用谷歌的AI渠道时,能够可视化和探查数据集。

经过量化数据要素,“可解说AI”能够给出更多见地,并让更多用户读懂这些见地。

“模型卡”将算法“黑匣子”翻开,供给有关特定算法具体实用信息

Google Cloud战略主管Tracy Frey说:“您能够将‘可解说AI’与咱们的假定剖析东西合作运用,以全面了解算法模型的行为。”

在某些范畴,例如医疗保健,进步AI的通明度将特别有用。例如,在某些疾病确诊的算法中,它会将医师确诊病症并给出决议计划的进程可视化,并验证这些症状不是假阳性或其他疾病的预兆。

谷歌还宣告将推出所谓的“模型卡”的新概念,即供给有关特定算法快速信息的简略文档。

这些文档实质上是用于机器学习的ID卡,这中心还包含有关模型功用和约束的具体实用信息。谷歌表明,这将“协助开发人员更好地决议将哪种模型用于什么意图,以及怎么担任任地布置它们。”

现在,Google已发布了两个模型卡示例,其间供给了有关人脸检测算法和目标检测算法的具体信息。

面部检测模型卡阐明,该算法或许会遭到面部尺度,方向或光线缺乏的约束。

图片:Google模型卡

用户都能够阅览有关模型输出的信息,如功用和局限性。例如,人脸检测模型卡阐明该算法或许遭到人脸尺度,方向或光线缺乏的约束。

这次,宣告的新东西和功用是Google证明其恪守AI准则的测验的一部分,该准则要求在开发该技能时进步通明度。而本年早些时候,谷歌解散了建立一周的AI品德委员会,该委员会旨在监督其谷歌对人工智能的运用。

参阅链接:https:///article/googles-new-ai-tool-could-help-us-unlock-the-mysteries-of-the-algorithms-that-decide-everything/